Tabla de contenido

INTROCUCCIÓN

1.2. Justificación del proyecto

1.4. Organización del documento

1.5. La doble utilidad del documento

1.6. Convenciones y tipografía

2.3. Requerimientos del proyecto

PRIMERA PARTE: SISTEMAS DE CLUSTERING

4.2. Sistemas de ficheros distribuidos

4.2.1.

Network File System (NFS)

4.3. Sistemas de ficheros paralelos

6.1. Funcionamiento de un sistema HA

6.2. Soluciones de HA en entornos Linux

SEGUNDA PARTE: DISEÑO E IMPLEMENTACIÓN

7. Estudio, análisis y diseño de una solución

7.1. Análisis del sistema inicial

7.2. Revisión de objetivos y requisitos

7.2.2.

Requisitos no funcionales

7.3.7.

Sistema de Monitorización

9.1. Arquitectura propuesta (versión 1.0)

9.2. Instalación (versión 1.0)

9.3. Configuración (versión 1.0)

9.3.1.

Consideraciones previas

9.5. Revisión de la arquitectura (versión 1.1)

9.6. Pruebas del nuevo modelo (versión 1.1)

10.1. Arquitectura propuesta (versión 2.0)

10.2. Instalación (versión 2.0)

10.3. Configuración (versión 2.0)

10.4.2.

Pruebas de rendimiento

11.1.1.

Instalación del Master host

11.1.2.

Instalación de un Execution host

11.2.1.

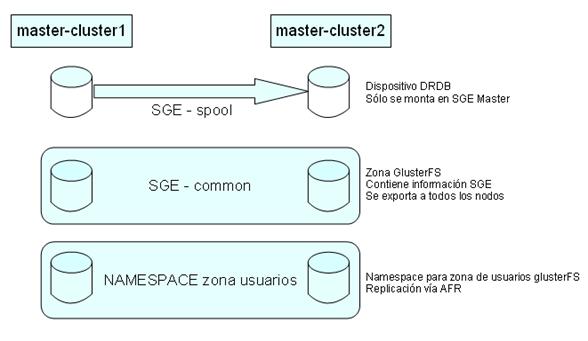

Zona Spool de mater hosts

12.2.1.

Cluster con GlusterFS (versión 2.0)

13.4. Personalización de imágenes

14.3.1.

Trabajos en ejecución:

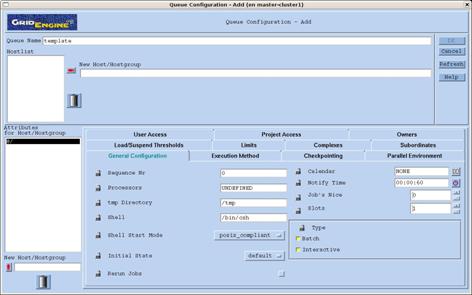

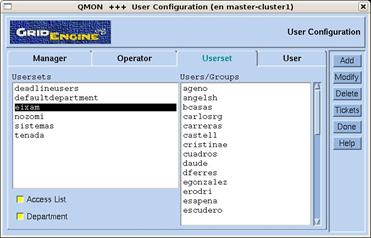

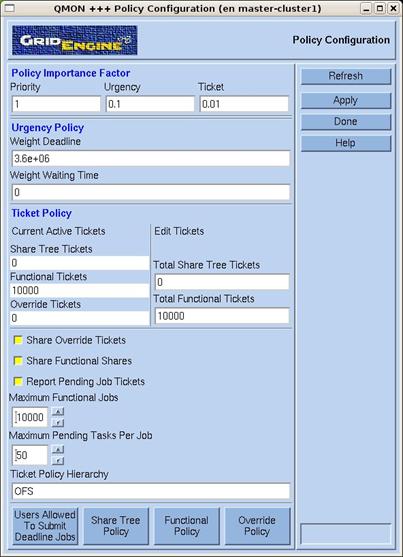

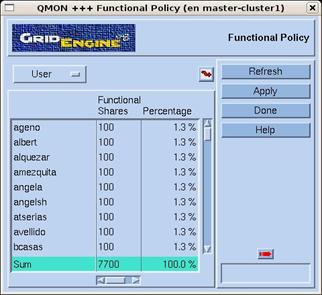

15.2.1. Configuración

en cliente

15.2.2.

Configuración en servidor

16.1.2.

Configuración del servidor

16.1.3.

Configuración de los clientes

TERCERA PARTE: CONCLUSIONES

18.1. Objetivos y requisitos cumplidos

18.2. Planificación y estudios de costes

18.2.1.

Planificación temporal

18.3. Mejoras y ampliaciones del sistema

18.3.1.

Infraestructura de red

18.3.3.

Sistema de almacenamiento

18.3.5.

Checkpointing (transparente) de procesos

APÉNDICES

19.1. Ficheros de configuración y scripts

19.1.3. Fichero glusterfs-server.vol

19.1.4. Fichero glusterfs-client.vol

19.1.5. Fichero ha.cf de master-cluster1

19.1.6.

Fichero ha.cf de master-cluster2

19.1.8. Script sungrid de heartbeat

19.1.9.

Fichero drbd.conf de zona spool

19.1.10. Fichero glusterfs-server_sge-common.vol

19.1.11. Fichero glusterfs-client-sge.vol

19.1.12. Fichero bootnode-gluster.shtml

19.1.17. Script jobs_run-slave.sh

19.1.18. Script jobs_queued.sh

19.1.20.

Fichero cluster_extra.tpl

19.1.21. Fichero meta_view.tpl

19.1.25. Fichero update.exim4.conf en master-cluster1

19.1.26.

Fichero update.exim4.conf en nodos de computación y servidores de disco

19.1.27. Fichero ntp.conf en nodos master-cluster

19.1.28.

Fichero ntp.conf en nodos de computación y servidores de disco

19.1.32. Script wakeup-cluster.sh

19.1.33. Script halt-cluster.sh

19.1.35.

Script alta_usuario.sh

19.1.36. Script build_users.sh

19.1.37. Script build_homes.sh

19.1.38. Script master_lectura.sh

19.1.40. Script test-disco_lectura.sh

19.1.41. Script

master_escritura.sh

19.1.43. Script test-disco_escritura.sh

19.1.44.

Fichero resultado_lectura.sh

19.1.45.

Listado de paquetes de software instalado

19.4. Referencias bibliográficas

1. Introducción

De igual manera que en la década de los 70s el advenimiento de los miniordenadores dio un giro a la idea de computación masiva, relegando a los poderosos y caros mainframes a aplicaciones prácticas muy concretas, hoy en día cada vez son más las empresas e instituciones, públicas y privadas, que se decantan por utilizar clusters en detrimento de grandes máquinas.

La idea que hay detrás de los clusters de computación es simple. Si la potencia de los ordenadores personales de hoy en día es considerable, ¿por qué no utilizar la potencia conjunta de unas decenas, centenares o incluso miles de éstos para que, trabajando conjuntamente, puedan llevar a cabo tareas más complicadas en un menor tiempo y a un menor coste?

En los últimos años, paralelamente al crecimiento en potencia del hardware, ha aumentado la cantidad y calidad de las soluciones software que proveen el sistema necesario para hacer que un conjunto de máquinas interconectadas trabajen al unísono como una gran máquina. Los avances en redes de computadores y el abaratamiento del hardware han contribuido a universalizar el uso de clusters.

Si bien la mayoría de las grandes empresas del sector informático han desarrollado algún sistema de clustering propio, no hay que menospreciar el esfuerzo de la comunidad open source que, contando con una cantidad ingente de desarrolladores en todo el mundo, ofrecen soluciones totalmente válidas que de hecho, se utilizan en las universidades más prestigiosas del mundo amen de muchas empresas punteras.

Este proyecto, ubicado en Laboratorio de Cálculo del Departamento de Lenguajes y Sistemas Informáticos (LCLSI), está formado por distintos grupos de investigación en los que se llevan a cabo tareas que requieren de una gran potencia de cálculo. Está claro que el modelo “ejecuto mis simulaciones en mi PC”, a estos niveles, no es una solución válida. Para dar respuesta a estas necesidades se barajan tres posibles opciones, que pasan por disponer de:

· Una máquina muy potente (muchas CPUs, mucha memoria)

· Alquiler de recursos de un superordenador (Marenostrum)

· Un cluster de computación propio, más escalable y económico.

Las dos primeras opciones pueden resultar prohibitivas para una sección de un Departamento como LSI, por exigir un fuerte desembolso inicial, de tal forma que la compra de un cluster parece lo más razonable. Y lo es más si tenemos en cuenta que la sección puede hacer un desembolso inicial, comenzar a explotar el hardware disponible e ir comprando más ordenadores (nodos) a medida que dispongan de los fondos necesarios.

1.1. Descripción del proyecto

El proyecto

que nos ocupa consiste en la implantación de un nuevo sistema de clustering o

computación masiva para el Departamento de Lenguajes y Sistemas Informáticos de

Las principales actividades del departamento son la docencia y la investigación. Es esta faceta la que requiere de una gran potencia de cálculo dada la complejidad y variedad de los proyectos que se tratan.

Durante este proyecto llevaremos a cabo un análisis de los requisitos para el nuevo sistema de clustering, estudiaremos las distintas opciones y realizaremos una propuesta que finalmente se implementará.

1.2. Justificación del proyecto

El Laboratorio de Cálculo de LSI, y por tanto el Departamento, viene utilizando clusters desde el año 2002. Actualmente hay principalmente tres grupos de investigación que utilizan clusters en LSI. Históricamente el primero de ellos se puso en marcha hace cinco años, dando servicio a unos pocos usuarios que hasta entonces ejecutaban sus trabajos en sus PCs de escritorio o en máquinas departamentales, carentes de la potencia necesaria.

En su día se optó por un sistema de clustering tipo SSI (Single System Image) bajo sistema operativo Linux. En este modelo todos los nodos del cluster cuentan con un kernel común modificado para que el conjunto del cluster se comporte como una sola máquina con tantas CPUs como nodos, donde las interconexiones de red sustituyen a las conexiones entre CPUs de un sistema multiprocesador. La gran ventaja de este modelo es la potente abstracción del hardware resultante: los usuarios del cluster pueden ejecutar sus procesos de la misma forma que lo hacen en su PC, despreocupándose del hardware subyacente. El middleware OpenMosix se encargaba de balancear la carga del cluster moviendo a discreción los procesos de un nodo a otro, buscando en cada momento la optimización de los recursos disponibles.

Esta solución, que ha funcionado bastante bien hasta la fecha, se topa con tres grandes problemas:

1. El sistema no cuenta con ningún mecanismo de protección ante sobrecargas por exceso de trabajos en ejecución, de tal forma que podría llegar a colapsarse cuando se lanzan tantos procesos como para consumir toda la memoria disponible.

2. El proyecto OpenMosix lleva años sin facilitar ninguna actualización, de tal manera que la versión más reciente sólo está disponible para un kernel antiguo que no soporta el hardware de los ordenadores más modernos, obligando a las secciones que quieren comprar nuevos nodos para su cluster a comprar hardware obsoleto.

3. El número de usuarios que utilizan los clusters crece continuamente (actualmente disponemos de unos 100 usuarios), por lo que es imperativo un sistema de colas para que los procesos se ejecuten de forma ordenada, maximizando la utilización del hardware en el tiempo.

La gestión del espacio de disco dentro del cluster es otro punto de vital importancia. Este modelo no cuenta con servidores de disco dedicados, sino que los nodos dedicados a computación exportan su espacio de disco al resto de nodos.

Nuevamente observamos tres problemas:

- Es engorroso para el usuario, que cuenta con tantas zonas de disco como nodos tiene el cluster (más de 20 zonas en algún cluster).

- El sistema de ficheros en red utilizado (NFS) produce un gran overhead en la red.

- No es tolerable a fallos. En caso de que uno de los nodos falle, los datos que se encuentran en su zona dejan de estar disponibles.

Desde el Laboratorio de Cálculo la propuesta que se realiza apuesta por cambiar el paradigma de clustering por uno basado en colas, más escalable, seguro, moderno y con garantías de continuidad.

Dado que las soluciones hardware de almacenamiento de disco dedicados quedan fuera de nuestro alcance, optamos por aprovechar el espacio de disco disponible en los nodos de la mejor manera posible, utilizando un sistema de ficheros en red distribuido y paralelo.

Tanto el sistema de colas como el sistema de ficheros deben ser tolerables a fallos, de tal forma que la caída de un nodo no comprometa el funcionamiento del resto del cluster ni a nivel de computación ni a nivel de disponibilidad de información.

1.3. Motivación personal

Durante nueve años he trabajado en el Laboratorio de Cálculo de LSI, primero como becario y más tarde como personal laboral. Durante este tiempo he desempeñando labores de administrador de sistemas, siempre ligado a entornos UNIX y a clusters de computación.

Mi motivación a la hora de encarar este proyecto no puede ser mayor, ya que se me presenta la oportunidad de continuar la labor comenzada seis años atrás cuando decidimos apostar por la tecnología cluster. Igualmente, qué mejor forma de corresponder el compromiso y agradecimiento recibido por parte de los usuarios que implementar un nuevo sistema, más potente y fiable que les permita obtener mayores cotas de productividad y satisfacción.

El desarrollo de este proyecto me ha permitido explorar el estado del arte de los distintos elementos que componen un cluster de computación. El punto de partida de cualquier proyecto de esta envergadura debe contemplar las soluciones ya implementadas.

En este sentido establecimos contacto con distintos departamentos de nuestra universidad como Arquitectura de Computadores, Matemática Aplicada I y administradores de sistemas del supercomputador Marenostrum, lo que nos permitió conocer de primera mano la forma de encarar la construcción de un cluster desde el punto de vista de departamentos similares al nuestro.

Una vez el

cluster entró en funcionamiento decidimos compartir la experiencia adquirida

con todos aquellos que nos abrieron sus puertas, así como todo aquel administrador

de sistemas de

Por otra parte los conocimientos adquiridos en el desarrollo de este proyecto han servido como base para la presentación de la ponencia que llevó por título Sistemes de computació d’altes prestacions i programari lliure en las VII Jornades de programari Lliure, que tuvieron lugar en Junio de 2008. La documentación de la ponencia puede consultarse en:

http://gabriel.verdejo.alvarez.googlepages.com/cluster

1.4. Organización del documento

Un cluster de computación es un sistema complejo, formado por multitud de elementos hardware y software en cuya construcción se realiza una verdadera labor de ingeniería. La optimización de los recursos disponibles buscando el máximo rendimiento al menor coste implica un conocimiento exhaustivo de las tecnologías que utiliza; a saber: sistemas operativos, redes de datos, software de clustering, filesystems paralelos, alta disponibilidad, etc.

Este documento consta de cuatro partes:

· Una primera parte de introducción donde se presentan los diferentes componentes de un cluster y se exploran diversas alternativas para cada componente

· Una segunda parte donde se realiza el análisis técnico del proyecto, se analizan las distintas alternativas y propone una solución.

· Una tercera parte que comprende la implementación de la solución propuesta, explicando el proceso de instalación y configuración de cada uno de los componentes y la implantación del nuevo cluster en sustitución del actual.

· Finalmente un apartado de bibliografía y anexos. Por lo general toda referencia aparecerá en los anexos.

Este documento pretende servir como obra de referencia en la construcción y mantenimiento de un cluster de computación. Se asume un cierto conocimiento de informática en general y de administración de sistemas UNIX en particular, ya que es imposible profundizar completamente en todos los temas tratados. De todas formas, el documento está redactado de forma que un lector menos experto, pero con interés, pueda seguir los procedimientos explicados obviando los detalles más técnicos.

1.5. La doble utilidad del documento

Este escrito, además de documentar este proyecto, pretende servir también como referencia a las personas encargadas de la administración del cluster.

En este sentido es interesante que, además de existir una copia en papel, exista una copia disponible en formato electrónico. Esto permitirá una mayor facilidad de consulta y abrirá la puerta a posibles correcciones y actualizaciones.

El cluster cuenta con su propio servidor web que, además de ofrecer servicios relacionados con la monitorización y administración del cluster sirve un repositorio de documentación propia:

http://master-cluster1.lsi.upc.edu/docu

En esta url, además de una copia de este documento, se encuentra información adicional como manuales y presentaciones.

1.6. Convenciones y tipografía

Para una mejor comprensión de este documento, dada la elevada naturaleza técnica de su contenido se seguirán una serie de convenciones tipográficas.

Convenciones tipográficas

Como ya se ha podido ver, los nombres propios de origen extranjero, así como los nombres de instituciones u organizaciones (como Departamento de Lenguajes y Sistemas Informáticos) aparecen en cursiva.

Igualmente, todos aquellos anglicismos que necesariamente aparecen en este texto, así como cualquier otro vocablo del ámbito de la informática, aparecerán también en cursiva la primera vez que se referencien. Lo mismo sucederá con palabras que, si bien son de origen foráneo, forman ya parte de nuestro lenguaje (como por ejemplo software).

Una parte importante de este proyecto consiste en código fuente de programas, contenido de ficheros datos y configuración, nombres de directorios, ficheros, etc. En estos casos el texto aparecerá en fuente de ancho fijo (como /etc/dhcp3), y los comandos o nombres de programas o scripts, además, en negrita (como check_sge.sh).

Convenciones no tipográficas

La ambigüedad propia del lenguaje también está presente, en gran medida, en los documentos de carácter técnico. De esta forma, a lo largo del documento, utilizamos indistintamente el término sistema de clustering para denotar tanto al hardware que conforma un cluster como al software que lo gobierna. Siempre que la utilización de estos términos pueda llevar a equívoco se aclarará su significado.

Siglas y acrónimos serán utilizados, previa introducción de su significado, para facilitar la lectura del texto.

2. Análisis preliminar

2.1. Situación actual

En el momento de comenzar este proyecto, el Departamento de Lenguajes y Sistemas Informáticos contaba con tres clusters de computación. Cada uno ellos propiedad de un grupo de investigación distinto.

El modelo HPC[1] utilizado basado en openMosix que proporcionaba un entorno confortable y productivo para la cantidad inicial de usuarios, ha quedado obsoleto ante el continuo crecimiento tanto en número de usuarios como en necesidades de cálculo y espacio de disco.

Igualmente, el esquema lógico de la infraestructura hardware así como el sistema que sustenta los datos de usuario, no cuentan con ningún mecanismo que proporcione tolerancia a fallos (caída de un nodo, fallo de un disco) ni alta disponibilidad.

Más adelante, en apartado [7.1] dedicado al análisis del sistema actual, se detallará a nivel técnico las carencias del modelo actual.

2.2. Objetivos del proyecto

La finalidad de este proyecto es doble. Por una parte, la sustitución de los clusters por uno nuevo que se adapte a las nuevas necesidades del Departamento y por otra, la creación de una documentación que sirva como referencia técnica al Laboratorio de Cálculo.

El sistema debe proveer a los usuarios un entorno de trabajo sencillo, amigable y proporcionar una escalabilidad que permita afrontar el futuro sentando unas bases sólidas.

2.3. Requerimientos del proyecto

Una vez expuestos los objetivos del proyecto, enumeraré los requerimientos que tendremos en cuenta a la hora de llevar a cabo el diseño y la implementación:

· La infraestructura hardware del nuevo cluster debe hacer uso del hardware existente (nodos, red y discos).

· Debe soportar una carga de trabajo superior a la actual, dada la tendencia creciente en cuanto a número de usuarios y, por tanto, de volumen de trabajo.

· Debe ser tolerable a fallos. El fallo de una parte del sistema no puede comprometer el funcionamiento del conjunto del cluster.

· Debe ser escalable, tanto a nivel de software como a nivel de infraestructura hardware.

En cuanto a la documentación, debe ser clara, concisa y no omitir información básica pero necesaria para el entendimiento completo de conceptos más complejos. Al fin y al cabo esta documentación debe permitir a cualquier persona cualificada del Laboratorio de Cálculo entender el funcionamiento del cluster y poder actuar en caso de que se produzca cualquier incidencia.

PRIMERA PARTE

SISTEMAS DE CLUSTERING

![]()

3. Clusters

En este apartado daremos una visión general de lo que es un cluster de cómputo, repasaremos brevemente su historia y los clasificaremos atendiendo a diversos criterios según la bibliografía existente.

3.1. ¿Qué es un cluster?

Cuando hablamos de Clusters en el ámbito de la computación nos referimos al conjunto de hardware y software que aglutina a grupos de ordenadores que, unidos mediante redes de alta velocidad, trabajan de forma conjunta en la resolución de problemas.

Los clusters se usan habitualmente para mejorar el rendimiento y/o la disponibilidad por encima de la que provee un solo ordenador, resultando mucho más económico que grandes ordenadores de velocidad y disponibilidad comparables.

Cualquier cluster ofrece uno o varios de los siguientes servicios:

· Alto rendimiento: el conjunto del cluster ofrece una capacidad computacional por encima de la de cualquiera de los elementos que lo conforman.

· Alta disponibilidad: la redundancia del hardware permite mantener el servicio que ofrecen aún y cuando falle alguno de los componentes del cluster.

· Balanceo de carga: la calidad de servicio mejora repartiendo el trabajo entre los nodos del cluster.

· Escalabilidad: la adición de nuevos elementos al cluster provoca un aumento proporcional de su capacidad.

En general, un cluster necesita de varios componentes software y hardware para funcionar:

· Nodos

· Sistema de almacenamiento

· Sistema Operativo

· Conexión de red

· Middleware

· Protocolos de comunicación y servicios

· Aplicaciones

Nodos

Pueden ser desde ordenadores corrientes hasta caros sistemas multiprocesador. En general, cuando hablamos de nodo dentro del ámbito de la computación nos referimos a cada uno de los ordenadores que lo conforman. Los nodos pueden ser dedicados si se dedican exclusivamente a labores del cluster o no dedicados si lo hacen de forma parcial o compartida con alguna otra tarea.

Sistema de almacenamiento

El sistema de almacenamiento en un cluster no es un tema baladí. En un cluster de tamaño medio puede haber cientos de nodos, cada uno ejecutando uno o varios trabajos que acceden simultáneamente a datos. Si estos datos no son accesibles de forma eficiente, el rendimiento del cluster se verá afectado.

Los sistemas de almacenamiento típicos son:

· NAS (Network Attached Storage): es un dispositivo dedicado al almacenamiento de datos y a su compartición en red. Cuenta con un sistema operativo optimizado que permite el acceso a los datos a través de diversos protocolos como CIFS y NFS.

· SAN (Storage Area Network): son unidades de almacenamiento externo que se conectan a uno o varios servidores.

· Discos locales: se utilizan los discos locales de los nodos, ya sean IDE, SATA, SCSI o SAS.

La elección de un sistema u otro depende en gran parte de la disponibilidad económica. Los discos duros locales siempre están disponibles en cualquier nodo que se adquiera y siempre pueden sustituirse por discos de mayor tamaño por poco dinero.

Los sistemas NAS y SAN son sistemas de un rendimiento superior pero que requieren de un desembolso inicial importante. Posteriormente estos sistemas pueden crecer añadiendo más discos.

Como lo habitual es que todos los nodos tengan acceso a los mismos datos, la información del sistema de almacenamiento disponible se exporta mediante algún sistema de ficheros distribuido como NFS (Network Filesystem) o distribuido paralelo como Lustre o GlusterFS.

Sistema operativo

El sistema operativo de un cluster debe ser multiproceso y multiusuario. Existen distribuciones específicas que se componen de un sistema operativo y del software de clustering, si bien también es posible añadir la capacidad de clustering a casi cualquier sistema operativo.

Sin lugar a dudas es dentro del mundo UNIX donde encontramos la mayor oferta de sistemas de clustering. Más concretamente Linux, dado su carácter libre y su gran difusión es, en cualquiera de sus variantes, el sistema operativo más extendido para estos sistemas de cómputo.

Conexión de red

La interconexión de los nodos juega un papel muy importante dentro de la arquitectura de un cluster, siendo una parte crítica en determinados tipos de clusters. No en vano las conexiones de red en un cluster vienen a ser lo que las conexiones interprocesador son en un ordenador multiprocesador.

La tecnología de conexión puede ser desde la más barata y extendida ethernet hasta las más caras y avanzadas como Myrinet o Infiniband. Estas últimas cuentan con mayor ancho de banda y menor latencia, la cual cosa las hace ideales para clusters de tipo HPC.

Middleware

El middleware es una pieza de software que se sitúa entre el sistema operativo y las aplicaciones con el fin de proveer:

· Abstracción del hardware: los usuarios ven el cluster como un único ordenador muy potente con el que interactúan, desentendiéndose de la arquitectura subyacente.

· Herramientas de gestión del sistema: migración de procesos, checkpointing, balanceo de carga, tolerancia a fallos, etc.

· Escalabilidad: detección e incorporación automática de nuevos nodos al cluster.

El middleware recoge los trabajos enviados al cluster por los usuarios y los distribuye entre los nodos de computación de la mejor manera posible, atendiendo a políticas más o menos sofisticadas de planificación.

Aplicaciones

Son las tareas que los usuarios envían al cluster. El sistema de clustering debe estar preparado para atender los requisitos de ejecución de las tareas, que pueden ser desde simples scripts a complejos programas paralelos. Estos últimos necesitan del apoyo de librerías de programación paralela como MPI o PVM, que deben integrarse adecuadamente en el sistema.

3.2. Un poco de historia

La bibliografía no fija una fecha concreta para el origen del término cluster pero es bien sabido que comenzó a utilizarse entre finales de los años 50s y principios de los 60s.

La idea de la explotación de sistemas de ordenadores como un medio para acelerar el cálculo paralelo data de 1967 cuando Gene Amdahl de IBM, publicó su famosa ley, que describe matemáticamente la ganancia esperada al paralelizar tareas en una arquitectura paralela. El artículo define la base para la ingeniería multiprocesador, que es extrapolable a clusters de computación, donde la comunicación interprocesador es sustituida por conexiones de red.

La historia de los primeros clusters trascurre paralela a la historia de las primeras redes. Una de las principales motivaciones para el desarrollo de las redes de entonces era conectar recursos de cálculo, creando de hecho un gigantesco cluster.

Las redes de conmutación de paquetes fueron inventadas por la corporación RAND en 1962. Utilizando esta tecnología, en 1969, el proyecto ARPANET creó la primera red de computadoras, que unían los recursos de cuatro centros de cálculo. El proyecto ARPANET creció hasta convertirse lo que hoy en día es Internet.

El desarrollo de PCs y clusters de grupos de investigación continuó de la mano con el de las redes y el sistema operativo Unix que a principios de los 1970s, ya incluía protocolos de comunicaciones de red como TCP/IP.

Pero no fue hasta 1983 cuando, gracias a los conceptos formalizados por BSD Unix e implementados por Sun Microsystems, el público contó con verdaderas herramientas que permitiesen la compartición recursos, como ficheros gracias a la inclusión del sistema de ficheros distribuido NFS.

ARCnet, el primer cluster comercial desarrollado por Datapoint en 1977, no tuvo una gran acogida. Sin embargo en 1984 Digital introdujo con gran éxito el VAXcluster, acompañado del sistema operativo VAX/VMS. Ambos sistemas no permitían el procesamiento paralelo, pero sí la compartición de recursos como archivos y periféricos.

Otros productos pioneros fueron el Tandem Himalaya en 1994 como producto de alta disponibilidad y el IBM S/390 Parallell Sysplex destinado a grandes empresas.

Cabe remarcar también el papel jugado por el software Parallel Virtual Machine (PVM), creado en 1989. Este proyecto open source basado en comunicaciones TCP/IP permitió la creación de superordenadores creados por cualquier cantidad de sistemas conectados por red. Rápidamente estos clusters superaron con creces la potencia de los grandes y caros superordenadores de la época.

Finalmente, en 1995 se creó el primer Beowulf, cluster con sistema operativo Linux caracterizado por utilizar ordenadores y redes convencionales con el fin único de procesar tareas paralelas con un gran throughput.

3.3. Tipos de cluster

El término cluster tiene diferentes connotaciones en función de los servicios que ofrecen. Si atendemos a una categorización según el fin para el que fueron concebidos, tenemos los siguientes tipos:

· HPC (High Performance Clusters o Clusters de Alto Rendimiento): Llevan a cabo tareas de una gran capacidad computacional, que ejecutadas en ordenadores corrientes serían inabarcables, ya sea por sus altos requisitos de memoria, potencia de cálculo o de ambas.

· HTC (High Throughput Clusters o Clusters de Alta Eficiencia): Están diseñados para llevar a cabo la mayor cantidad de tareas en el menor tiempo posible. Los datos de las tareas son individuales entre si y la latencia entre los nodos no es tan importante como en los clusters HPC.

· HA (High Availability Clusters o clusters de Alta Disponibilidad): También conocidos como clusters Failover, su principal cometido es mejorar la disponibilidad de los servicios que proporciona. Su arquitectura se compone de nodos redundantes que proveen el servicio cuando algún componente falla.

Normalmente están formados por dos nodos, que es lo mínimo necesario para tener redundancia. La existencia de redundancia en el hardware evita tener un único punto de fallo, maximizando así la disponibilidad.

Parte del éxito de los clusters radica en su extrema flexibilidad desde el punto de vista de la arquitectura. En este sentido encontramos las siguientes categorías:

· Clusters Homogéneos: Todos los nodos cuentan con el mismo hardware y sistema operativo.

· Clusters Heterogéneos: Nodos con diferente hardware y sistema operativo.

· Clusters Semihomogéneos: Hardware y sistemas operativos similares, pero con distinto rendimiento.

4. Cluster Filesystems

Cuando hablamos de un sistema de ficheros para un cluster se suele pensar en sistemas de ficheros complejos, extraños y alejados de los utilizados habitualmente en sistemas más convencionales. Nada más lejos de la realidad. Un cluster no tiene porqué contar con el filesystem más complejo ni con el que usan los clusters más potentes, ni siquiera con uno concebido a tal efecto. Para cada cluster, o mejor dicho, dependiendo del uso y de la exigencia que se vaya a dar, hay un abanico enorme de posibilidades que van desde filesystems distribuidos ordinarios a complejos filesystems paralelos.

4.1. Glosario

En este apartado estudiaremos algunos filesystems susceptibles de ser utilizados dentro de un cluster de computación como el que proyectamos. Antes es necesario dar algunas definiciones para facilitar su comprensión:

· Filesystem: método de almacenamiento y organización de ficheros y los datos que permite su búsqueda y acceso.

· Servidor: máquina que pone a disposición de otras máquinas (clientes) conectadas por red un sistema de ficheros.

· Cliente: máquina que accede al sistema de ficheros de una máquina remota (servidor).

· Daemon: o demonio es un programa que se ejecuta en segundo plano (background) de forma indefinida encargado de recibir y procesar peticiones.

· Automounter: sistema que monta sistemas de ficheros bajo demanda, reduciendo así el overhead de mantener la conexión entre servidor y clientes cuando los clientes no están accediendo al filesystem remoto.

· Bloqueo: o en inglés lock, es un mecanismo que permite asegurar la integridad de los datos cuando son accedidos de forma concurrente.

· Stripe: aplicado a filesystems paralelos, cada una de las partes en que se divide un fichero y que son guardadas en servidores de datos distintos para aumentar el rendimiento de lectura y escritura.

· Network filesystem o distributed filesystem: es un sistema de ficheros que soporta la compartición de ficheros, impresoras u otros recursos de forma persistente a través de una red.

· Parallel filesystem: sistemas de ficheros distribuidos que distribuyen los datos en varios servidores para obtener un mayor rendimiento. Suelen utilizarse en clusters de alto rendimiento (HPC).

4.2. Sistemas de ficheros distribuidos

Un sistema de ficheros distribuido se muestra a los usuarios como un sistema de ficheros local convencional. La multiplicidad y la dispersión de los servidores y su almacenamiento queda oculto. De hecho, los programas que tratan con datos no distinguen si éstos son locales o no.

El rendimiento esperado de un sistema de ficheros distribuido es menor que el de un sistema de ficheros local, ya que al tiempo de acceso a disco y proceso de CPU hay que sumar el overhead producido por la comunicación por la red. Esto incluye el tiempo de realizar la petición al servidor y el tiempo en obtener la respuesta en ambas direcciones más el overhead de CPU que provoca el protocolo de comunicaciones.

4.2.1. Network File System (NFS)

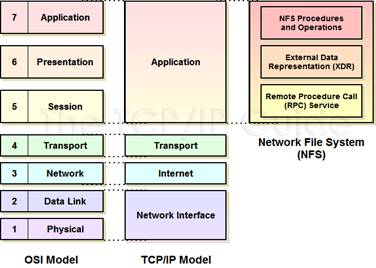

NFS es un

protocolo de nivel de aplicación según el modelo OSI que se utiliza en sistemas de archivos distribuidos en redes de

área local. Permite que distintos sistemas conectados a una misma red tengan

acceso a ficheros remotos como si fueran locales. Fue desarrollado en 1984 por Sun

Microsystems con el objetivo de que fuera independiente de la máquina, el

sistema operativo y el protocolo de transporte.

Figura 4.1. El protocolo NFS en los modelos OSI y TCP/IP

El protocolo NFS está incluido por defecto en los sistemas operativos UNIX. NFS utiliza un esquema cliente-servidor, donde los clientes acceden de forma remota a los datos que se encuentran almacenados en el servidor.

Los clientes utilizan menos espacio de disco, ya que los datos están centralizados en un servidor, evitando así tener datos replicados. La centralización del home de usuarios es un uso habitual de NFS dentro de organizaciones.

Todas las operaciones sobre ficheros son síncronas. Esto quiere decir que la operación sólo retorna cuando se ha completado el trabajo asociado, que en el caso de una escritura será cuando el servidor escriba físicamente los datos en disco. De esta forma la integridad de los ficheros queda garantizada.

Actualmente hay tres versiones en uso:

· Versión 2: originalmente desarrollada sobre UDP, es la más antigua y está soportada por muchos sistemas operativos.

· Versión 3: incluye soporte 64 bits que permite manejar ficheros de más de 4 GB, escrituras asíncronas para mejorar el rendimiento, atributos extendidos y en algunas implementaciones, soporte TCP como transporte.

· Versión 4: influenciado por AFS y CIFS, incluye cambios orientados a mejorar el rendimiento y la seguridad como soporte Kerberos y ACLs.

4.2.2. Samba

Samba es un software opensource para sistemas UNIX que implementa el protocolo SMB (Server Message Protocol) de archivos compartidos de Microsoft Windows, que permite la compartición de ficheros e impresoras entre sistemas Windows y UNIX.

Samba implementa una docena de protocolos entre los que se encuentran NetBIOS, WINS la suit de protocolos de dominio NT, Active Directory y SMB, también conocido como CIFS.

Como hemos comentado, Samba permite la compartición de recursos en sistemas heterogéneos. Ahora bien, limitaciones como la incompatibilidad con los atributos de ficheros y los enlaces simbólicos de los sistemas de ficheros del mundo UNIX, lo desaconsejan como filesystem distribuido para clusters formados exclusivamente por máquinas UNIX.

4.3. Sistemas de ficheros paralelos

Los sistemas de ficheros distribuidos paralelos surgen de la necesidad de solucionar los problemas que nos encontramos al utilizar sistemas de ficheros distribuidos convencionales en clusters de computación.

Sistemas de ficheros distribuidos como NFS provocan un gran overhead de red que en condiciones de E/S intensiva llegan a saturar el acceso a los datos. Si imaginamos un escenario con un cluster de tamaño medio de unos pocos centenares de nodos es fácil hacerse a la idea de la cantidad ingente de peticiones de E/S que pueden generarse en un disco compartido.

Los sistemas de ficheros distribuidos paralelos solucionan este problema reduciendo el overhead de red y distribuyendo los datos entre varios servidores para paralelizar las lecturas y escrituras.

4.3.1. GPFS

General Parallel Filesystem (GPFS) es un sistema de ficheros distribuido paralelo desarrollado por IBM. Proporciona acceso compartido concurrente de alta velocidad a aplicaciones que se ejecutan en distintos nodos de un cluster.

Inicialmente fue diseñado para soportar las altas tasas de transferencia requeridas por las aplicaciones multimedia, pero su diseño resultó muy adecuado para la computación científica. Fue desarrollado en 1993, pero no vio la luz comercialmente hasta 1998 cuando fue publicado para el sistema operativo AIX. Desde 2001 también hay disponible una versión para Linux.

El principio de funcionamiento de GPFS es el mismo que el de cualquier sistema de ficheros paralelo. En un cluster de almacenamiento GPFS hay nodos servidores, que almacenan datos, y nodos clientes que acceden a ellos. Cuando se realiza una operación de escritura sobre este filesystem los datos se trocean y se distribuyen en tiras (stripes) que son almacenadas en varias máquinas servidoras de disco. De esta forma se obtiene un mayor rendimiento al acceder a los distintos bloques en paralelo. Además GPFS permite alta disponibilidad, ya que los datos pueden guardarse replicados en varios servidores.

4.3.2. Lustre

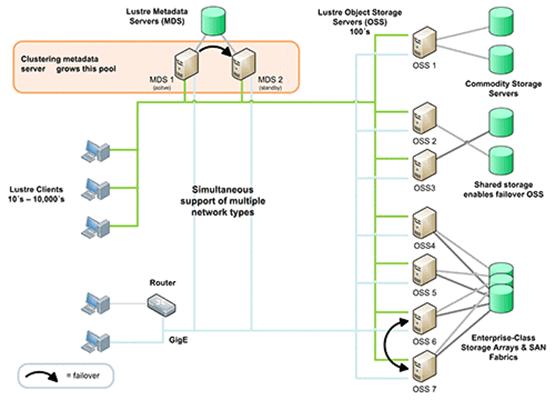

Lustre es un sistema de ficheros distribuido paralelo para clusters escalable, robusto y con alta disponibilidad. Desarrollado y mantenido por Sun Microsystems, está disponible bajo licencia GNU GPL.

Proporciona un sistema de almacenamiento que escala correctamente desde sistemas con decenas de nodos y terabytes de capacidad de almacenamiento hasta grandes clusters con decenas de miles de nodos con petabytes de información.

Lustre es considerado el mejor filesystem distribuido paralelo. De hecho 15 de los 30 mayores superordenadores del mundo[2] hacen uso de Lustre y su gran escalabilidad.

Durante la fase de pruebas/integración comprobaremos si, el que sobre el papel es el mejor sistema de ficheros distribuido paralelo, se adapta a nuestras necesidades. Nuestro sistema de cluster no llega al centenar de nodos y tiene algunas limitaciones hardware por lo que, como veremos, será necesario aunar distintas tecnologías para tener un sistema funcional.

Figura 4.2: Ejemplo de cluster Lustre

4.3.3. GlusterFS

GlusterFS es un sistema de ficheros paralelo distribuido, disponible bajo licencia GNU v3, capaz de escalar hasta varios petabytes. GlusterFS aglutina varias unidades de almacenamiento independientes en un gran sistema de ficheros paralelo sencillo y altamente escalable. Cada unidad de almacenamiento cuenta con su propia CPU, memoria, bus de E/S, almacenamiento RAID e interfaz de red. El rendimiento pico teórico sería el rendimento agregado de todas las unidades. GlusterFS está diseñado para escalar linealmente en clusters de gran tamaño.

El servidor GlusterFS permite exportar volúmenes sobre la red. El cliente GlusterFS monta los volúmenes del servidor en el kernel VFS. La mayor parte de la funcionalidad de GlusterFS está implementada mediante translators.

La idea de translator está basada en el sistema operativo GNU/Hurd (http://hurd.gnu.org). Los Translators son un mecanismo muy potente que permite a GlusterFS extender sus capacidades a través de un interfaz bien definido. Los translators del lado cliente y servidor son compatibles, por lo que se pueden cargar indiferentemente en cada parte. Son objetos binarios compartidos (.so) que se cargan en tiempo de ejecución según el ficheros de especificación del volumen.

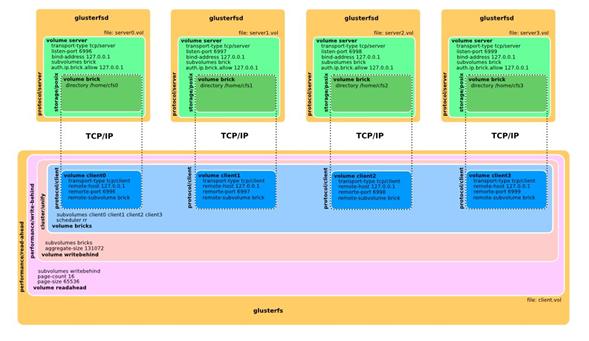

Figura 4.3: Ejemplo de configuración de GlusterFS con 4 nodos de almacenamiento y 1 nodo cliente

5. Software de Clustering

Como hemos visto en el capítulo [3] no basta con conectar una serie de ordenadores en red para tener un cluster. Es necesario un software o middleware que se encargue de distribuir los trabajos de los usuarios entre los nodos disponibles de forma óptima.

A continuación veremos varios ejemplos de sistemas de clustering, profundizando especialmente en openMosix por ser el middleware de los tres clusters en producción. Más adelante, en el análisis del sistema actual (apartado [7.1]), volveremos a hablar de openMosix y expondremos las limitaciones que nos han llevado a su sustitución.

5.1. openMosix

openMosix

tiene su origen en Mosix, un sistema

de clustering SSI (Single System Image), cuyo desarrollo comenzó en 1981 en

A finales de 2001 Mosix deja de distribuirse bajo licencia GPL, y es entonces cuando nace openMosix, la versión abierta de Mosix, bajo licencia full GPL2. Esto permitió que el proyecto openMosix contase con una amplia comunidad respaldándolo y contribuyendo a su desarrollo.

OpenMosix es un software que permite que ordenadores conectados en red funcionando bajo GNU/Linux trabajen de forma cooperativa. Es capaz de balancear automáticamente la carga entre los diferentes nodos del cluster y permite la adición o sustracción de nodos en caliente sin necesidad de interrumpir el servicio.

La carga se distribuye entre los distintos nodos atendiendo a parámetros como tipo de conexión, memoria disponible y velocidad de CPU.

Dado que openMosix forma parte del kernel y mantiene total compatibilidad con Linux, los programas de usuario, ficheros y otros recursos funcionarán igualmente sin cambio alguno. El usuario final no notan diferencia alguna entre ejecutar sus aplicaciones en su sistema Linux o en un cluster openMosix. Para ellos, la totalidad del cluster se presenta como un gran sistema multiprocesador.

OpenMosix consta de un parche de kernel Linux compatible con plataformas IA32. Este parche introduce las modificaciones necesarias en el kernel que permiten la comunicación entre los nodos del cluster. Todos los nodos de un cluster openMosix cuentan con el mismo kernel modificado, de ahí el nombre de cluster Single System Image (SSI).

El algoritmo de balanceo de carga migra los procesos entre los distintos nodos de forma transparente, intentando optimizar su utilización en todo momento, si bien el administrador puede modificar manualmente este algoritmo.

El hecho de

que la migración de procesos se haga de forma transparente hace que el conjunto

del cluster se muestre como un gran sistema multiprocesador (SMP) con tantos procesadores

disponibles como el sumatorio de los procesadores de todos los nodos.

Figura

5.1: Arquitectura de un cluster tipo SSI

Características

de openMosix

· Alta escalabilidad.

· Algoritmo adaptativo de balanceo de carga.

· Migración dinámica de procesos.

· Middleware de clustering en kernel, por lo que no son necesarias librerías externas.

· Totalmente transparente a usuario y aplicaciones.

· Fácil instalación y administración.

· Posibilidad de añadir y eliminar nodos en caliente.

· Integración con librerías de paralelización MPI/PVM.

Funcionamiento

de openMosix

OpenMosix consta de una parte de sistema (kernel space) y otra de usuario (user space):

La parte de usuario dispone de una serie de herramientas que permiten monitorizar el cluster y la modificación del comportamiento por defecto de openMosix.

La parte de sistema consiste en un parche de kernel que a su vez consta de cuatro subsistemas:

- Migración de procesos: Cada proceso tiene su nodo raíz (UHN, Unique Home Node) que se corresponde con el nodo que lo ha creado. El concepto de migración implica la división del proceso en dos partes: la parte de sistema y la de usuario. La parte de sistema (deputy) permanece en su UHN durante toda la vida del proceso, mientras que la parte de usuario puede moverse libremente por todos los nodos del cluster.

Figura 5.2: División de procesos en openMosix

El sistema de migración utiliza algoritmos del campo de la economía para decidir cuándo migrar un proceso. A cada recurso (CPU, memoria, E/S) de cada nodo se le da un coste.

Estos costes son unificados en un GFC (global cost function). El valor del CFG de un nodo no se publicita a todo el cluster, sino a un subconjunto aleatorio de sus vecinos.

Los procesos son migrados al nodo donde tienen el menor coste: se obtiene así la distribución más “económica” posible. Cada proceso puede migrar cuantas veces sea necesario.

- Memory ushering: Este subsistema se encarga de migrar las tareas que superan la memoria disponible en el nodo en el que se ejecutan. Las tareas que superan este límite son migradas forzosamente a otros nodos con la suficiente memoria como para ejecutar el proceso sin necesidad de hacer swap a disco, evitando así una gran pérdida de rendimiento.

- Mosix File System (MFS): MFS permite que sistemas de ficheros de nodos remotos sea accesibles localmente. Si se habilita esta opción en el kernel, el sistema de ficheros del nodo local y los demás aparecerán montados en /mfs.

- Direct File System Access (DFSA): esta opción permite a los procesos hacer operaciones de E/S de forma local en nodos remotos. Sin DFSA, cada operación de E/S que se produzca en un nodo “migrado” será enviada al UHN, donde se resolverá.

5.2. Condor

Condor es un

software que crea un entorno de computación HTC formado por estaciones de

trabajo UNIX conectadas en red. Fue creado por

Condor puede configurarse para utilizar los ciclos libres en máquinas conectadas a la red y que no están pensadas como máquinas de computación, como de PCs de escritorio. En este caso, en momentos en los que estas máquinas no son utilizadas pasan a formar parte del cluster. Cualquier evento de usuario como un input de teclado o ratón, provoca que la máquina salga del cluster.

Este modelo es especialmente interesante para organizaciones que cuentan con una gran número de PCs de usuario con muchos ciclos libres; por ejemplo, durante las noches o fuera del horario laboral. Durante estos espacios de tiempo, el cluster Condor crecería considerablemente, incrementando notablemente el thoughput de cómputo.

5.3. PBS

PBS (Portable Batch System) es un sistema de

trabajos batch y un sistema de

gestión de recursos. Fue desarrollado por

PBS consta de cuatro componentes:

· Commands: PBS proporciona una serie de comandos en línea así como un interfaz gráfico, ambos conforme al estándar POSIX 1003.2d. Estos comandos permiten enviar, monitorizar, modificar y borrar trabajos.

· Job Server: es la parte central de PBS. Todos los comandos y daemons se comunican con el servidor. La principal función de éste es proveer los servicios batch básicos como recibir y crear un trabajo, modificarlo, protegerlo de posibles caídas del sistema y ponerlo en ejecución.

· Job Executor: es el daemon que realmente pone el trabajo en ejecución. Su nombre, mom, se debe a que es la madre de todos los procesos en ejecución. Mom pone en ejecución el trabajo cuando recibe una copia del servidor. También reproduce la sesión del usuario propietario del trabajo (shell, .login, .csh, etc). Finalmente, al acabar el trabajo, devuelve la salida al usuario.

· Job Scheduler: este daemon contiene las políticas que controlan qué trabajo, cuándo u dónde se ejecutan los trabajos.

5.4. Sun Grid Engine

Sun Grid Engine (SGE) es un sistema de gestión de colas open source desarrollado por Sun Microsystems.

En el año 2000 Sun adquirió Gridware, empresa especializada en sistemas de gestión de resursos de computación para ofrecer una versión free de Gridware para Solaris y Linux a la que llamó Sun Grid Engine.

En 2001, liberó el código y adoptó el modelo de desarrollo open source, tras lo que surgieron ports para otros sistemas UNIX.

Es un sistema altamente configurable, sencillo de de administrar y de utilizar por parte de los usuarios. Su escalabilidad lo ha llevado a ser el sistema de clustering de mayor éxito entre los mayores clusters de supercomputación.

Como sistema de gestión de colas, SGE se encarga de aceptar, planificar y ejecutar grandes cantidades de trabajos. También se encarga de la gestión y planificación de recursos distribuidos como procesadores, memoria, disco y licencias de software.

Un cluster Sun Grid se compone de un master host y uno o más execution host. Además pueden configurarse múltiples shadow hosts como hot spares capaces de tomar el control del master host cuando falle, proporcionando alta disponibilidad.

Al igual que Condor y PBS, Sun Grid trabaja con shellscripts que definen los requisitos de los trabajos de los usuarios, pero además puede tratar directamente con binarios e incluso ejecutar trabajos interactivos.

Se trata, sin lugar a dudas, del producto más completo disponible en el mercado, tanto por rendimiento como por facilidad de uso y capacidad de configuración. A todo esto hay que sumar el hecho de que se trata de un proyecto opensource con una comunidad de desarrolladores y administradores ingente y, algo de lo que pecan otros proyectos, el respaldo de una empresa del prestigio como Sun Microsystems.

6. Alta disponibilidad

En el apartado [3.3] hemos visto que los clusters HA o de alta disponibilidad son un tipo de clusters con nodos redundantes encargados de mantener un servicio en caso de fallo hardware. En este capítulo explicaremos los principios básicos de la alta disponibilidad.

En servicios críticos suelen implementarse sistemas tolerables a fallos (fault tolerant o FT) en los que el servicio siempre está disponible. Estos sistemas son extremadamente caros, por lo que suelen quedar fuera del abasto de empresas e instituciones de tamaño medio.

Los sistemas de alta disponibilidad intentan obtener prestaciones cercanas a la tolerancia a fallos a un precio mucho menor. La alta disponibilidad está basada en la replicación de elementos, lo que resulta mucho más barato que contar con un solo elemento tolerable a fallos.

A efectos prácticos, la diferencia entre los sistemas tolerables a fallos y los de alta disponibilidad es el periodo de tiempo en el cual el servicio no está disponible (downtime). En sistemas tolerables a fallos este tiempo no existe, mientras que en los sistemas de alta disponibilidad se intenta minimizar pero existen, pudiendo ser de unos segundos a varios minutos, dependiendo del timeout que decide si el sistema ha fallado.

Un sistema de alta disponibilidad se basa en la replicación de elementos, ya sean piezas hardware concretas o servidores completos, tomando como modelo los RAID (Redundant Array of Independent Disks). El objetivo de la replicación es eliminar los puntos de fallo únicos (SPOF, Single Point of Failure). Cualquier elemento no replicado es susceptible de fallar y producir un corte en el servicio. Cuando lo que se replica es un servidor completo hablamos de un cluster HA.

6.1. Funcionamiento de un sistema HA

A continuación definiremos una serie de conceptos básicos para la alta disponibilidad:

Failover

Es el nombre genérico que se da a un nodo que puede asumir la responsabilidad de otro, importar sus recursos y levantar sus servicios. Cuando se da esta situación, en el caso de servicios con nodos duplicados, nos encontramos temporalmente en un escenario de SPOF hasta que el administrador restaure el nodo caído.

Takeover

Es un failover automático que se produce cuando un nodo detecta el fallo de otro. Para ello es necesario mecanismos de monitorización del servicio. Debe haber mecanismos que obliguen al nodo fallado a ceder sus servicios para evitar inconsistencias de funcionamiento.

Switchover o Giveaway

Es un failover manual que consiste en ceder los servicios del nodo que ha fallado a otro nodo mientras se llevan a cabo las actuaciones administrativas pertinentes.

Splitbrain

Para la gestión de un cluster HA es necesario un mecanismo de comunicación y verificación de los nodos que lo integran. Cada nodo debe gestionar sus propios recursos según el estado del cluster a la vez que chequea el estado de los otros nodos y servicios.

Se produce un splitbrain cuando la comunicación entre los nodos falla. En esta situación cada nodo cree que es el único activo y como no puede saber el estado de su compañero considera que ha fallado y fuerza un takeover.

Esta situación es peligrosa, ya que los dos nodos intentan apropiarse de los recursos. El peligro es aún mayor cuando el servicio es, por ejemplo, un sistema de almacenamiento de datos, en el que cada nodo podría escribir por su cuenta y provocar corrupción de datos.

Para solucionar este tipo de situaciones, cuando un nodo detecta un fallo reserva un recurso compartido llamado quórum. El quórum es un recurso exclusivo, que sólo puede ser reservado por un nodo. El nodo que intente reservarlo y no pueda entiende que debe abandonar el cluster y ceder sus servicios.

6.2. Soluciones de HA en entornos Linux

A continuación analizamos algunas soluciones que implementan mecanismos de alta disponibilidad en entornos Linux:

Heartbeat

Heartbeat es considerado como el estándar de facto de la alta disponibilidad en entornos Linux. Se engloba dentro del proyecto Linux-HA (Linux High Availability) y es ampliamente adoptado por miles de clusters en todo el mundo que proveen servicios críticos.

Heartbeat forma parte de la mayoría de las distribuciones Linux, si bien se trata de un software altamente portable que corre sin problemas en sistemas FreeBSD, Solaris, OpenBSD y MacOS/X. Cuenta con licencia GPL. Sus principales características son:

· No hay limitación en el número de nodos que puede monitorizar. Puede utilizarse para monitorizar desde clusters sencillos hasta clusters muy grandes.

· Monitorización de recursos: los recursos pueden relanzarse o moverse a otro nodo en caso de fallo.

· Dispone de sofisticadas políticas de gestión de recursos.

· Permite definir distintas políticas en función del tiempo.

· Incluye scripts para la gestión de recursos como BBDD, servidores web, filesystems, siendo fácil crear scripts personalizados para nuevo servicios.

LVS

LVS (Linux Virtual Server) permite crear clusters de balanceo de carga, en los que un nodo master se encarga de gestionar y repartir las conexiones entre varios nodos slave. LVS puede llegar a gestionar hasta 200 nodos slave.

Ldirectord es un daemon que se ejecuta en el nodo master LVS que se encarga de comprobar el servicio en los nodos slave y eliminarlos e insertarlos en el cluster dinámicamente.

En la práctica resulta un producto menos versátil que heartbeat.

Piranha

Es el nombre de la solución de RedHat basada en LVS, a la que se ha añadido una interfaz de usuario que facilita su configuración.

UltraMonkey

Es una variante de LVS creada por VA Linux que utiliza Heartbeat para ofrecer clusters de alta disponibilidad con balanceo de carga. En este tipo de clusters se añade un segundo nodo master para eliminar el SPOF de los clusters LVS.

SEGUNDA PARTE

DISEÑO E IMPLEMENTACIÓN

![]()

7. Estudio, análisis y diseño de una solución

Una

vez explicados los distintos componentes que forman un cluster, estamos en

disposición de revisar las especificaciones y concretar los requisitos de

nuestro proyecto.

El análisis de los requisitos nos llevará a lo largo del proyecto a plantear varios diseños y arquitecturas[3] posibles para el nuevo cluster, que tras implementarlos y llevar a cabo las pertinentes pruebas de integración, estabilidad y rendimiento nos conducirán a la propuesta final.

7.1. Análisis del sistema inicial

En

el apartado [2.1] hemos introducido los clusters existentes en el Departamento

de LSI. A continuación realizaremos un análisis en profundidad de sus

componentes y su funcionamiento.

El

Departamento de LSI tiene tres clusters de computación. Cada uno de ellos era

independiente de los otros, tanto a nivel físico como lógico. Se trata de tres

clusters del mismo del mismo tipo, diferenciándose sólo en el número de nodos

que lo conforman.

A

nivel hardware, cada cluster está compuesto de una serie de máquinas (PCs

enracables) conectados a una red privada mediante un switch gigabit ethernet. Una de las

máquinas está conectada a la red de LSI y a la red privada del cluster,

sirviendo de puerta de acceso al mismo.

A

nivel software todas las máquinas que pertenecen a un mismo cluster cuentan con

el mismo sistema operativo y la misma imagen de kernel, requisito

imprescindible al tratarse de máquinas con un sistema de clustering tipo SSI.

Cada

máquina cuenta con uno o dos discos duros, en cuyo caso se configuran en modo

RAID1[4],

en los que se crea una partición para datos de usuario. Esta partición se

exporta al resto de máquinas del cluster por NFS, de tal forma, que en cada

nodo del cluster tenemos N zonas NFS montadas, una por cada una de las N

máquinas que componen el cluster.

La

figura [7.1] muestra el esquema de los clusters actuales, con un nodo de acceso

y N máquinas dedicadas a cómputo y a servidor disco.

Los

motivos que nos llevan a abandonar este modelo de cluster son los siguientes:

·

openMosix

o

No tiene ningún mecanismo de limitación de recursos: cualquier

usuario puede, en un momento dado, lanzar tantos procesos como quiera y saturar

un nodo o el cluster completo.

o

Presenta problemas con varios tipos de aplicaciones: el mecanismo de

migración automática de openMosix no funciona con aplicaciones que hacen uso de

threads o memoria compartida.

o

Estrechamente ligado al kernel: openMosix impone el kernel de los

nodos, siendo el más reciente de la rama 2.4, sin soporte para el hardware de

los nuevos nodos.

o

Proyecto cancelado el

Figura

7.1: Esquema de cluster openMosix de LSI

·

Sistema de zonas de disco NFS

o

N zonas: Cada usuario tiene tantas zonas como nodos hay en el

cluster. Se hace difícil controlar dónde están los datos.

o

Fragmentación del espacio: no se aprovecha correctamente todo el

espacio disponible.

o

Rendimiento de NFS: bajo

situaciones de estrés con multitud de accesos concurrentes las zonas exportadas

por NFS tienen un rendimiento mediocre.

7.2. Revisión de objetivos y requisitos

Recordemos

que este proyecto tiene dos objetivos:

- La

implantación de un nuevo sistema de cluster para el Departamento de LSI.

- La

creación de una documentación de referencia y administración para el

Laboratorio de Cálculo de LSI.

Tras

exponer los conceptos necesarios para entender el funcionamiento de las partes

que conforman un cluster de computación, procedemos a realizar el análisis de

los requisitos del nuevo sistema.

7.2.1. Requisitos funcionales

Veamos

qué servicios debe prestar el nuevo cluster.

- En

primer lugar, el nuevo cluster debe ofrecer un servicio igual al que

ofrece el sistema actual, es decir, debe ser capaz de procesar los

trabajos de los usuarios y debe disponer de un espacio de disco para

albergar sus datos y programas en un sistema de disco centralizado.

- El

middleware elegido debe ser personalizable a nivel de gestión de colas,

proyectos, grupos de usuarios, etc.

- Además

debe contar con un software de gestión de imágenes de sistema que permita

instalar y modificar fácilmente el sistema en los nodos que la componen,

de forma que la instalación y posterior mantenimiento de los nodos (más de

50) sea asumible.

- El

cluster debe ser monitorizable, es decir, el administrador debe tener las

herramientas necesarias para controlar el estado de sus componentes y

percatarse de cualquier fallo.

7.2.2. Requisitos no funcionales

- El

nuevo cluster también debe cumplir ciertos requerimientos de eficacia y

seguridad. Concretamente debe ser capaz de soportar una mayor carga de

trabajo y debe ser capaz de mantener el servicio a pesar del fallo de

cualquiera de sus componentes.

- Como

hemos comentado, el número de usuarios de los clusters ha crecido

considerablemente los últimos años y con ellos el volumen de trabajo que

el cluster debe procesar. El nuevo sistema debe ser capaz de procesar el

volumen actual y futuro de trabajo haciendo uso del hardware disponible.

En este sentido, el aumento del volumen de trabajo por encima de cierto

umbral nunca debe llevar a un fallo en el cluster.

- El

incremento del número de usuarios trae consigo una mayor necesidad de

capacidad de almacenamiento de datos. El nuevo cluster debe contar con un

sistema rápido, no fragmentado, transparente y escalable, que pueda crecer

cuando sea necesario.

- Se establece una batería de

pruebas o benchmarks (ver

apartado [19.3]) encaminados a

probar la estabilidad, el rendimiento y la usabilidad de los sistemas

propuestos.

7.3. El nuevo cluster

Una vez introducidos los conceptos necesarios y descritos los distintos componentes del nuevo sistema estamos en disposición de explicitar y analizar la solución propuesta.

En primer lugar describiremos el sistema base, es decir, la infraestructura hardware y software que sustentará el sistema de clustering. Los siguientes puntos detallarán cada uno de los componentes y servicios un cluster de computación.

7.3.1. El sistema base

Uno de los requerimientos no funcionales del proyecto es que debemos reutilizar el hardware que conforman los tres clusters existentes.

Contamos, inicialmente, con el hardware de los tres clusters de LSI:

· 20 nodos de eixam

· 10 nodos de tenada

· 10 nodos de nozomi

· 1 switch 3Com gigabit de 48 puertos

· 2 switches 3Com gigabit de 16 puertos

· 3 Multiplexadores de puertos KVM

Además de estos nodos, cada grupo había comprado nodos que aún no habían sido instalados porque su hardware no era compatible con el kernel de openMosix:

· 6 nodos de eixam

· 4 nodos de tenada

· 6 nodos de nozomi

Algunos de estos nodos cuentan con discos de gran capacidad (750GB) que utilizaremos para crear el filesystem distribuido.

Figura 7.2: El CPD de UPC en el edificio Omega

El nuevo cluster estará ubicado en el CPD de UPC (Edificio Omega en el Campus Nord), donde se encuentran todos los servidores del Departamento de LSI. Por cuestiones de limitación de espacio llegamos a un acuerdo con los responsables de los clusters para liberar espacio retirando las máquinas más obsoletas. Se retiran máquinas Pentium IV con chasis de 2U, que además son poco eficientes desde el punto de vista energético.

Los nodos de entrada de los tres clusters antiguos también se retiraron. Se trata de máquinas menos potentes ya que, por la naturaleza descentralizada de openMosix, su única función era proveer acceso a la red del cluster.

Además se llega al acuerdo con los distintos grupos de investigación de comprar dos máquinas que correrán los servicios principales del cluster, que proporcionarán alta disponibilidad y servirán como punto de entrada al cluster. Ambos servidores son idénticos, y cuentan con las siguientes características:

- Dell PowerEdge R200

- Procesador Intel Xeon E3110 a 3 Ghz, 6 MB de cache

- 8 GB de memoria RAM

- 2 tarjetas de red gigabyte Ethernet

- 2 discos SAS de 450 GB

- Chasis enrackable de 1U

Todos los nodos cuentan con sistema operativo Linux Debian. La elección de esta distribución viene dada por ser el sistema operativo utilizado en todos los servidores y estaciones de trabajo Linux del Departamento de LSI. Debian es una distribución con gran tradición dentro del mundo Linux, estable, con un repositorio de software importante y muy enfocado hacia el segmento de los servidores. Concretamente se ha escogido la versión Etch por ser la versión estable en el momento de desarrollar este proyecto.

La instalación del sistema operativo es igual en todas las máquinas, con la única diferencia de los servicios que ejecutan, que se personalizan mediante scripts creados a tal efecto.

Siempre que ha

sido posible se ha instalado el software vía el repositorio oficial de Debian.

El listado completo de los paquetes instalados puede encontrarse en los

apéndices [

7.3.2. Sistema de pruebas

A excepción de las máquinas compradas más recientemente, que no pueden correr openMosix, el resto del hardware pertenece a alguno de los tres clusters existentes. Así pues, para hacer las pruebas de los distintos subsistemas del nuevo cluster crearemos una réplica a escala de lo que será el futuro cluster. El diseño modular nos permitirá abstraernos del número y tipo de máquinas instaladas.

El cluster de pruebas está formado por:

- 16 nodos Dell con procesadores Intel Xeon de doble o cuádrule núcleo y 4 u 8 GB de memoria RAM.

- 1 switch 3Com gigabit de 16 puertos

- 1 multiplexador de puertos KVM

7.3.3. Software de clustering

Como sistema de gestión para el nuevo cluster hemos elegido Sun Grid Engine, que es quizás el sistema de colas más utilizado, tanto en ámbitos empresariales como en centros de investigación.

Se trata de un producto estable, maduro, con gran tradición dentro del ámbito de la supercomputación y que cuenta con una numerosísima comunidad de usuarios y administradores. Se trata, en fin, de uno de los proyectos de clustering más vivos que además es de código abierto.

7.3.4. Sistema de ficheros

Nuestra primera opción como filesystem fue Lustre, de SunMicrosystems. Se trata del sistema de ficheros distribuido paralelo más potente y escalable disponible y se adapta perfectamente a entornos de clustering. Como veremos, las peculiaridades y limitaciones de nuestro hardware harán que el filesystem no rinda como se esperaba y nos veremos obligados a revisar nuestra elección. El overhead del sistema software de sincronización de discos castiga el rendimiento en exceso, motivo por el que desechamos Lustre en nuestra solución. Más adelante se explica con detenimiento los problemas que nos encontramos.

La segunda opción fue GlusterFS, un filesystem más modesto, no tan escalable pero que en entornos medianos como el nuestro, y con hardware no tan dedicado, puede dar un rendimiento adecuado.

7.3.5. Alta disponibilidad

Como software de alta disponibilidad elegimos Heartbeat, que forma parte del proyecto Linux-HA y que es el sistema de alta disponibilidad más extendido en el mundo Linux.

Se trata de un sistema de monitorización sencillo capaz de comprobar el status de dos hosts unidos por una conexión dedicada. Su funcionamiento es simple: si la conexión de uno de los hosts se interrumpe, el host que queda en funcionamiento toma el control de los servicios que han caído.

Este mecanismo de monitorización nos proporcionará alta disponibilidad de los servicios de clustering y de sistema de ficheros, protegiéndonos ante el fallo de uno de los nodos master o de cualquiera de los nodos servidores de disco.

7.3.6. Sistema de imágenes

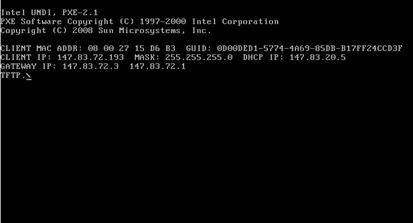

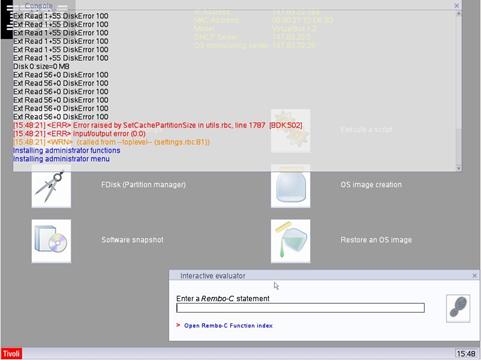

Desde que pusimos en marcha el primer cluster, vimos que era necesario disponer de un sistema de replicación de imágenes de sistema que permitiese automatizar la gestión del software de las máquinas del cluster. Instalar un nodo manualmente es un proceso tedioso que consume un tiempo, instalar N nodos de esta forma no es práctico. La elección en su día fue Rembo. Se trata de un software que permite una gran personalización de las imágenes gracias a su sistema de scripts y con un amplio soporte de tarjetas ethernet. Además contamos con licencia de campus UPC.

En 2006 IBM adquirió Rembo, incorporándolo dentro de su suite Tivoli. Dadas las buenas experiencias obtenidas con Rembo nos decidimos a utilizar Tivoli, que también cuenta con licencia UPC.

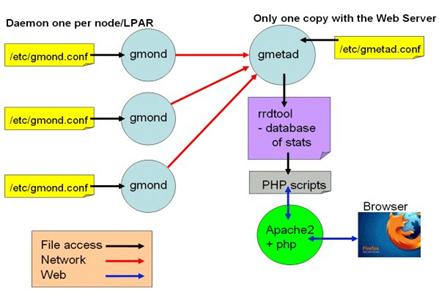

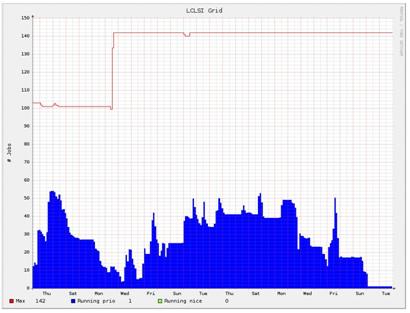

7.3.7. Sistema de Monitorización

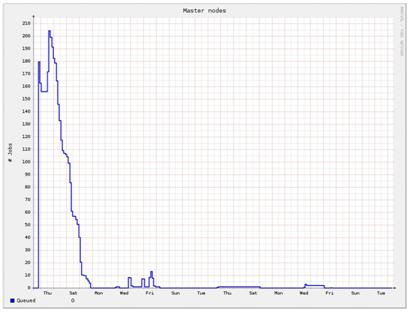

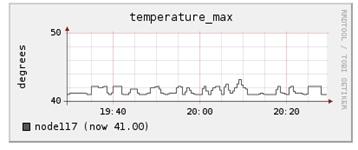

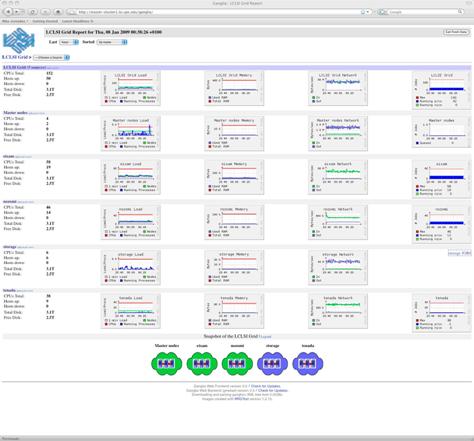

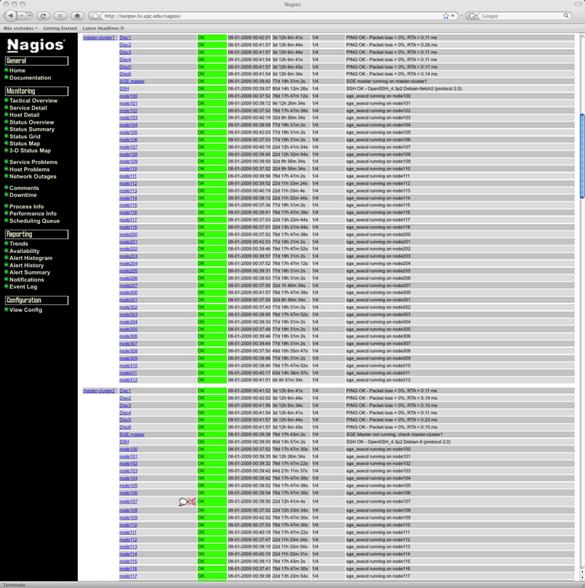

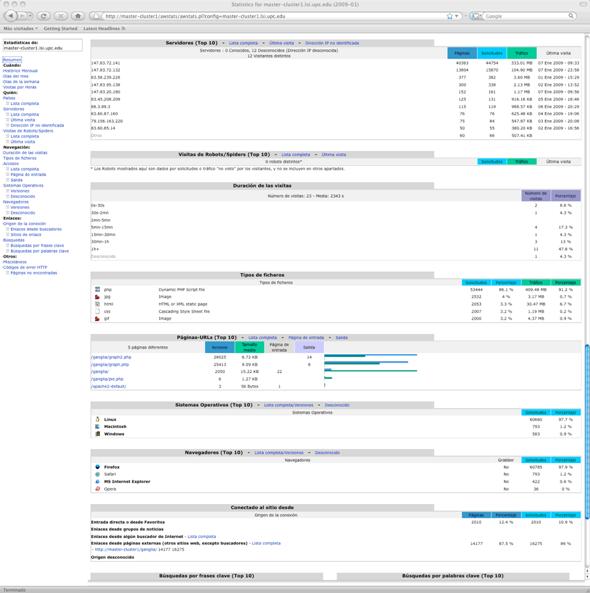

El interés de monitorización es doble. Por una parte queremos un sistema que nos informe del estatus del cluster y que sea capaz de aglutinar toda la información generada por la gran cantidad de elementos que lo conforman. La información mostrada debe adaptarse tanto a las necesidades de los administradores del sistema como a los usuarios. En este sentido ganglia proporciona un interfaz web perfectamente adaptado a la idiosincrasia de los clusters, y que con algunas modificaciones se adapta perfectamente a nuestra infraestructura.

Por otra parte, como administradores de sistemas, necesitamos saber el estatus de los componentes del cluster. De poco sirve tener un sistema de alta disponibilidad con dos hosts si al caer uno de ellos no somos informados. En el Laboratorio de Cálculo todos los servicios críticos se monitorizan con el sistema operativo (so), así que lo que haremos será incluir los servicios del cluster dentro del sistema de monitorización nagios de LCLSI.

7.3.8. Servicios auxiliares

Además de los componentes propios del cluster, son necesarios una serie de servicios complementarios para el correcto funcionamiento del sistema. Servicios como:

· Servicio de nombres, que se encarga de la correspondencia entre las direcciones IPs de los nodos y sus nombres.

· Servicio de correo, que permite la gestión de los emails administrativos generados por los nodos de computación dentro de SunGrid.

· Servicio de tiempo. Configuraremos nuestro propio servidor de tiempo que mantendrá la hora de todos los nodos sincronizada.

· Servicio de backup. Incorporamos el espacio de disco compartido del cluster al sistema de backups departamentales.

8. Implementación

Una vez diseñado el nuevo sistema, describiremos la implementación del diseño propuesto.

Primero nos centraremos en el proceso de instalación y configuración de cada uno de los servicios que conformarán el Cluster:

· Lustre o GlusterFS como sistema de ficheros.

· SunGrid como sistema de clustering.

· Heratbeat como sistema de alta disponibilidad.

· Tivoli como sistema de replicación de imágenes.

· Ganglia y Nagios como sistemas de monitorización.

· Otros servicios (DHCP, correo, tiempo, etc).

Cabe notar que tanto en la instalación como en la configuración de cada uno de estos componentes seguiremos una serie de reglas:

· Siempre que sea posible utilizaremos el software proporcionado por el sistema operativo, lo que nos permitirá mantener el software actualizado fácilmente.

· Todo el software adicional común se instalará en un directorio dentro de /usr/local, accesible en cada nodo para todos los usuarios.

· Los distintos componentes del cluster se instalarán de forma independiente y lo más aislados posibles del resto del sistema operativo. Esto nos permitirá actuar en cada uno de ellos sin afectar al resto.

· Se tratará de independizar el cluster, en la medida de lo posible, del resto de servicios del Departamento, lo que nos proporcionará una robustez añadida.

9. Lustre

9.1. Arquitectura propuesta (versión 1.0)

Uno de los objetivos del nuevo cluster es proporcionar a los usuarios un espacio de disco unificado, solucionando el problema de zonas de usuario fragmentadas en el modelo de los clusters anteriores. En este volumen único, que será visible desde todos los nodos del cluster, los usuarios guardarán sus programas, datos, salidas de procesos, etc.

Todas las máquinas del cluster cuentan con un espacio de disco libre que va desde los 60 GB en las máquinas más antiguas con discos de 80 GB hasta más de 700 GB en las máquinas más modernas. El espacio total resultante de sumar todos estos volúmenes da como resultado una cantidad de disco considerable.

Lustre como sistema de ficheros paralelo permite crear un volumen unificado a partir de diferentes espacios de disco heterogéneo accesible por conexiones TCP/IP. Estos espacios de disco pueden ser NAS, SAN o, como en nuestro caso, hosts con discos locales.

Un sistema Lustre cuenta con tres unidades funcionales principales:

1. Un metadata target (MDT) por filesystem que almacena metadatos, como nombres de ficheros, directorios, permisos y file layout en el metadata server (MDS).

2. Uno o más object store targets (OSTs) que guardan los datos de los ficheros en uno o más object storage servers (OSSs). Dependiendo del hardware de los servidores, un OSS normalmente sirve entre dos y ocho targets, con cada target un sistema de ficheros en disco local con hasta 8 terabytyes de tamaño. La capacidad de un sistema Lustre es la suma de las capacidades de los targets.

3. Cliente(s) que acceden y usan los datos.

MDT, OST y cliente pueden estar en distintos nodos o en el mismo. En general estas funciones se separan en nodos distintos, de dos a cuatro OSTs por nodo OSS. Lustre soporta varios tipos de redes, incluyendo Infiniband, TCP/IP en ethernet, Myrinet, Quadrics y otras tecnologías propietarias.

El MDT y los OSTs pueden contar con un nodo configurado como failover que es capaz de acceder a sus datos en caso de que el nodo servidor falle.

La figura [4.2] en el apartado [4.3.2] muestra el esquema de un cluster

Lustre complejo, con diversos OSSs con OSTs albergados en SANs, sistemas de

failover, etc.

La alta disponibilidad es uno de los objetivos que nos hemos marcado a la hora de diseñar el nuevo espacio de disco. Aprovechando las facilidades que proporciona Lustre, dotaremos de alta disponibilidad tanto al MDT como a los distintos OSTs. En nuestro caso esto implica tener dos hosts sirviendo el MDT y otros dos por cada OST. El segundo host, configurado como failover, debe ver el mismo disco que el host primario para ser capaz, en caso de fallo de éste, de tomar el control y continuar sirviendo disco.

Lo más habitual en sistemas de alto rendimiento es disponer de un SAN (Storage Area Network) conectado a dos hosts. El SAN en estos casos cuenta con varias controladoras que permiten su conexión a distintos hosts. Los hosts se configuran como primary y failover. El nodo primary es el que sirve el disco a la zona Lustre. En caso de caída del nodo primary, Lustre se dará cuenta y automáticamente comenzará a utilizar el nodo failover.

En nuestro

caso utilizaremos los discos locales de las máquinas como espacio de disco

compartido. Agruparemos las máquinas del cluster por parejas. Habrá una pareja que sirva el

MDT y el resto de parejas servirán OSTs.

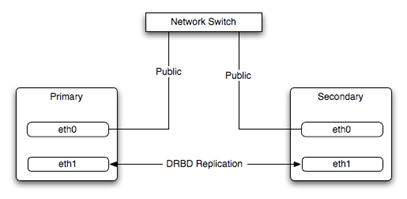

Figura

9.1: Esquema de dos hosts con replicación de datos vía conexión de red dedicada

Cada uno de los hosts tienen acceso solamente a su disco local, y Lustre sólo "habla" con el host que actúa como primario. Es necesario algún mecanismo adicional que replique los datos que se escriben en el host primario al failover. Es más, esos datos deben mantenerse estrictamente sincronizados para evitar problemas de incoherencia de datos. En este sentido DRBD (Distributed Replicated Block Device) nos proporciona un mecanismo transparente de replicación de bloques entre dispositivos, particiones de discos duros en este caso, que se encuentran en hosts conectados por red. Algunas características de DRBD son:

· Trabaja en tiempo real. La replicación de datos es continua, mientras las aplicaciones modifican el contenido del dispositivo.

· Es transparente. Las aplicaciones que trabajan en el dispositivo replicado no son conscientes de que los datos están en varios servidores.

· La replicación puede ser síncrona o asíncona. Trabajando de forma síncrona, las escrituras por parte de aplicaciones se consideran finalizadas sólo cuando la escritura se ha realizado en los dos servidores que conforman el dispositivo replicado. La replicación asíncrona implica que las escrituras se consideran finalizadas cuando se han completado de forma local, antes de que se hayan propagado al peer.

Dos hosts compartiendo un dispositivo de bloques DRBD juegan roles primary y secondary. El host primary es el host que monta el dispositivo DRBD y es sobre su disco físico local sobre el que se realizan las lecturas. Las escrituras se realizan en primer lugar en el disco del host primary y posteriormente en el host secondary. En nuestro caso configuraremos DRBD en modo síncrono, de tal forma que una escritura no se considerará realizada hasta que no se haya realizado en los discos de los hosts primary y secondary.

Los roles primary y secondary se corresponden con los roles primary y failover de Lustre.

Figura

9.2: Arquitectura del cluster con Lustre (versión 1.0)

La replicación de datos entre parejas de hosts se realizará utilizando una conexión de red dedicada, tal y como se muestra en la figura [9.2]. Todos los nodos del cluster cuentan con al menos 2 interfaces de red gigabit ethernet. La interconexión de los hosts de cada pareja mediante una conexión de este tipo permite que la sincronización de datos se realice de forma óptima, sin ocupar el ancho de banda de la red privada del cluster.

Como hemos comentado anteriormente, Lustre es capaz de detectar el fallo de un servidor, ya sea de un MDT o de un OST, y utilizar en su lugar un host configurado como failover. En el caso por ejemplo de un OST formado por dos hosts en configuración failover sirviendo el disco de un SAN, si fallase el host primary, el host failover tendría acceso de forma "automática" al SAN y Lustre pasaría a comunicarse con él. En nuestro caso, con las zonas replicadas con DRBD, necesitamos un mecanismo extra que nos permita detectar el fallo del host primary y que, en caso de fallo, configure el host seconday como primary y monte la zona DRBD. Heartbeat, tratado en el capítulo [12], permite monitorizar el estatus de servicios de alta disponibilidad y ejecutar scripts que los activen/desactiven.

9.2. Instalación (versión 1.0)

9.2.1. DRBD

La funcionalidad principal de DRBD está implementada como módulo del kernel. Concretamente, DRBD proporciona un driver para un dispositivo de bloques especial.

La última versión disponible es la 8.2.6, que podemos descargar de la url:

http://oss.linbit.com/drbd/8.2/drbd-8.2.6.tar.gz

Como con todo el software que instalamos y que no viene con la distribución de software del sistema operativo, dejamos copia en /root/files.

Compilamos e instalamos el software:

master-cluster1>

tar xvfz drbd-8.2.6.tar.gz

master-cluster1>

cd drbd-8.2.6/drbd

master-cluster1> make && make install

El módulo de kernel queda instalado en el directorio correspondiente a dispositivos de bloques en /lib/modules y las utilidades de administración en /sbin.

Comprobamos que el módulo carga correctamente:

master-cluster1> modprobe drbd

El siguiente mensaje indica que el módulo se ha cargado:

drbd:

initialised. Version: 8.2.6 (api:88/proto:86-88)

Para automatizar el proceso de carga del módulo drbd al iniciar el sistema, lo incluimos en el fichero /etc/modules.

9.2.2. Lustre

Lustre está dividido en tres partes:

- Parches de kernel

- Módulo de kernel

- Utilidades de espacio de usuario